![图片[1]-Meta带来Transformer新突破:结束人工智能推理能力「黑核化」?-开放智能](https://nimg.ws.126.net/?url=http%3A%2F%2Fdingyue.ws.126.net%2F2024%2F0225%2F3283a08aj00s9dvtp00d3d200l600eeg00it00cs.jpg&thumbnail=960x2147483647&quality=75&type=jpg)

Transformer架构在生成式人工智能诸多领域展现出非凡的能力:GPT3,GPT3.5,GPT4,sora, Llama2 ,Gemini,通义千问,文心一言等等全部建立在Transformer上。然而,在解决复杂的规划与推理任务方面,尤其是涉及多步骤决策制定时,Transformer架构及其衍生出的大规模语言模型(LLMs)仍面临挑战,无法媲美传统的符号规划方法。

Meta公司旗下的FAIR团队的研究人员Lucas Lehnert等人提出了Searchformer这一创新方案,它利用Transformer模型优化求解以往未见过的Sokoban谜题等复杂规划任务,并且在保证解决方案最优的情况下,其搜索步骤相比标准的A*搜索最多可减少26.8%。Searchformer通过模仿并超越经典的A*搜索策略,为Transformer模型在解决复杂规划问题上开辟了一条新路径,不仅提升了模型在不同类型的决策任务上的推理能力,也为构建更加通用且无需预设人类知识即可自动习得推理和规划机制的神经网络架构奠定了基础

![图片[2]-Meta带来Transformer新突破:结束人工智能推理能力「黑核化」?-开放智能](https://nimg.ws.126.net/?url=http%3A%2F%2Fdingyue.ws.126.net%2F2024%2F0225%2F7fff626bj00s9dvtr00c8d200u000j0g00it00bw.jpg&thumbnail=960x2147483647&quality=75&type=jpg)

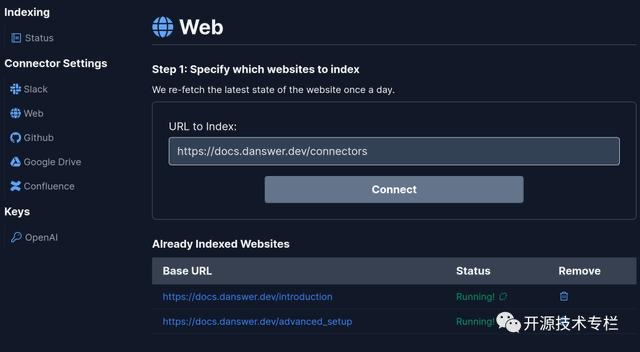

研究人员首先通过运行随机生成的规划任务实例中的A*搜索,生成一套合成数据集。这些数据集中包含了A*执行过程的详细记录,即所谓的搜索动态序列,表现为一系列标记化的词语序列,其中包含任务状态的添加和移除等信息。然后,研究人员训练一个Transformer模型去生成这样的标记序列及相应的最优计划。

进一步地,研究者通过专家迭代的方法对已学习模仿A*搜索过程的Searchformer进行微调,使其在保持最优解决方案的同时,能以更少的搜索步骤解决问题。实验证明,在迷宫导航和解决Sokoban难题等多步骤规划任务中,Searchformer表现出色,尤其在解决Sokoban谜题时,成功率高达93.7%,且平均搜索步数比A*算法明显缩短。

为了探究训练数据类型和模型参数数量对性能的影响,研究团队进行了消融实验。他们对比了仅使用“解决方案”序列(仅包含任务描述和最终计划的标记序列)以及使用“增强搜索”序列(包含任务描述、搜索树动态以及最终计划的标记序列)两种情况下的模型表现。结果显示:

尽管“增强搜索”序列长度可达数千个标记,但以此训练出的模型仍然能够高效地生成正确的搜索动态和最优计划。特别值得注意的是,相较于仅训练于“解决方案”序列的模型,“增强搜索”模型在面对未见过的任务时,即使训练样本量仅为前者的十分之一,也能更频繁地生成最优计划,这充分证明了将A*搜索动态融入Transformer训练过程的重要性。

此外,与其他依赖合成数据集提升推理能力的工作不同

本研究的核心在于直接改进Transformer内部蕴含的推理能力,而非将其视为黑盒模型并通过现有符号规划技术改善神经网络本身,这项成果标志着在利用Transformer进行高效复杂规划方面的研究迈出了坚实一步,对推进人工智能推理决策能力具有重要意义

例如,AlphaZero、MuZero等算法虽然在强化学习环境中表现出色,但在处理如Searchformer这样的任务时,它们并未尝试让Transformer模型直接模仿和超越经典规划算法。Searchformer的独特之处在于,它借鉴了A*搜索的执行轨迹,实现了搜索动态引导的自举学习,从而有效地推广至更高效的搜索模式,并实现自我优化。

研究论文:https://arxiv.org/pdf/2402.14083.pdf