![图片[1]-ControlNet作者又出新作:百万数据训练,AI图像生成迎来图层设计-开放智能](https://nimg.ws.126.net/?url=http%3A%2F%2Fdingyue.ws.126.net%2F2024%2F0308%2F03770a91j00sa0d3e0039d200u000u0g00id00id.jpg&thumbnail=960x2147483647&quality=75&type=jpg)

尽管用于生成图像的大模型已经成为计算机视觉和图形学的基础,但令人惊讶的是,分层内容生成或透明图像(是指图像的某些部分是透明的,允许背景或者其他图层的图像通过这些透明部分显示出来)生成领域获得的关注极少。这与市场的实际需求形成了鲜明对比。大多数视觉内容编辑软件和工作流程都是基于层的,严重依赖透明或分层元素来组合和创建内容。

来自斯坦福大学的研究者提出了一种「latent transparency(潜在透明度)」方法,使得经过大规模预训练的潜在扩散模型能够生成透明图像以及多个透明图层。

![图片[2]-ControlNet作者又出新作:百万数据训练,AI图像生成迎来图层设计-开放智能](https://nimg.ws.126.net/?url=http%3A%2F%2Fdingyue.ws.126.net%2F2024%2F0308%2F0c350410j00sa0d3f001ud200u00070g00id004a.jpg&thumbnail=960x2147483647&quality=75&type=jpg)

-

论文地址:https://arxiv.org/pdf/2402.17113.pdf

-

论文标题:Transparent Image Layer Diffusion using Latent Transparency

举例来说,对于给定的文本提示(如头发凌乱的女人,在卧室里),该研究提出的方法能够生成具有透明度的多个图层。也就是说该模型不仅能根据提示生成图片,还能将前景和背景进行分层,背景丢失的信息也能很好的补充。

![图片[3]-ControlNet作者又出新作:百万数据训练,AI图像生成迎来图层设计-开放智能](https://nimg.ws.126.net/?url=http%3A%2F%2Fdingyue.ws.126.net%2F2024%2F0308%2F9b02848ej00sa0d3i00xed200u000v1g00id00iz.jpg&thumbnail=960x2147483647&quality=75&type=jpg)

此外,本文还采用人机交互的方式来训练模型框架并同时收集数据,最终数据集的规模达到 100 万张透明图像,涵盖多种内容主题和风格。然后,该研究将数据集扩展到多图层样本。该数据集不仅可以训练透明图像生成器,还可以用于不同的应用,例如背景 / 前景条件生成、结构引导生成、风格迁移等。

实验表明,在绝大多数情况下 (97%),用户更喜欢由本文方法生成的透明内容,而不是以前的解决方案(例如先生成然后抠图)。当研究者将生成的质量与 Adobe Stock 等商业网站的搜索结果进行比较时,也取得了不错的成绩。

这项研究作者共有两位 Lvmin Zhang 以及 Maneesh Agrawala ,其中 Lvmin Zhang 还是 ContorlNet 的作者。

有网友表示:「能生成透明图层的意义绝不仅仅是抠图。这是现在动画、视频制作最核心的工序之一。这一步能够过,可以说 SD 一致性就不再是问题了。」

![图片[4]-ControlNet作者又出新作:百万数据训练,AI图像生成迎来图层设计-开放智能](https://nimg.ws.126.net/?url=http%3A%2F%2Fdingyue.ws.126.net%2F2024%2F0308%2Fb36ce1adj00sa0d3j002dd200u0005ig00id003d.jpg&thumbnail=960x2147483647&quality=75&type=jpg)

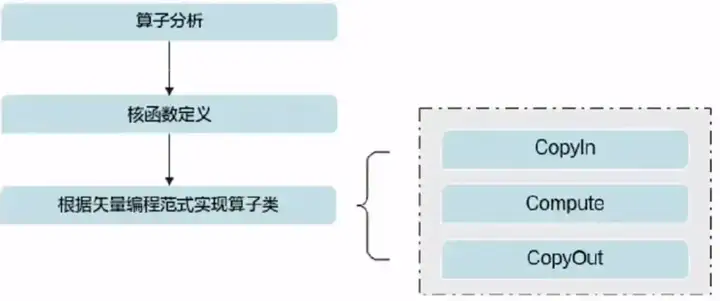

方法介绍

本文的目标是为像 Stable Diffusion (SD) 这样的大规模潜在扩散模型添加透明度支持,这些模型通常使用一个潜在编码器(VAE)将 RGB 图像转换为潜在图像,然后再将其输入到扩散模型中。在此过程中,VAE 和扩散模型应共享相同的潜在分布,因为任何重大不匹配都可能显著降低潜在扩散框架的推理 / 训练 / 微调性能。

潜在透明度:当调整潜在空间以支持透明度时,必须尽可能保留原始的潜在分布。这个看似不明确的目标可以通过一个直接的测量来确定:可以检查修改后的潜在分布被原始预训练的冻结潜在解码器解码的如何 —— 如果解码修改后的潜在图像创建了严重的人工痕迹,那么潜在分布就是不对齐或损坏的。这一过程可视化结果如下图所示:

![图片[5]-ControlNet作者又出新作:百万数据训练,AI图像生成迎来图层设计-开放智能](https://nimg.ws.126.net/?url=http%3A%2F%2Fdingyue.ws.126.net%2F2024%2F0308%2Fed5f7ce6j00sa0d3k00ahd200u000atg00id006m.jpg&thumbnail=960x2147483647&quality=75&type=jpg)

生成多个图层:该研究进一步使用注意力共享和 LoRA 将基础模型扩展为多图层模型,如图 3-(b) 所示。图 3-(a) 为训练可视化结果。

![图片[6]-ControlNet作者又出新作:百万数据训练,AI图像生成迎来图层设计-开放智能](https://nimg.ws.126.net/?url=http%3A%2F%2Fdingyue.ws.126.net%2F2024%2F0308%2F344813cfj00sa0d3l00grd200u000mkg00id00ds.jpg&thumbnail=960x2147483647&quality=75&type=jpg)

图 4 引入了几种替代架构,以实现更复杂的工作流程。研究者可以向 UNet 添加零初始化通道,并使用 VAE(有或没有潜在透明度)将前景、背景或图层组合编码为条件,并训练模型生成前景或背景(例如,图 4-( b,d)),或直接生成混合图像(例如,图 4-(a,c))。

![图片[7]-ControlNet作者又出新作:百万数据训练,AI图像生成迎来图层设计-开放智能](https://nimg.ws.126.net/?url=http%3A%2F%2Fdingyue.ws.126.net%2F2024%2F0308%2Fd287c817j00sa0d3m0058d200u000eug00id0092.jpg&thumbnail=960x2147483647&quality=75&type=jpg)

数据准备及其训练细节

训练数据集包括基础数据集(图 5-(a))以及多图层数据集 (5-(b)) 。

![图片[8]-ControlNet作者又出新作:百万数据训练,AI图像生成迎来图层设计-开放智能](https://nimg.ws.126.net/?url=http%3A%2F%2Fdingyue.ws.126.net%2F2024%2F0308%2F58025a51j00sa0d3o00kvd200u000svg00id00hn.jpg&thumbnail=960x2147483647&quality=75&type=jpg)

训练设备为 4 × A100 80G NV-link,整个训练时间为一周(为了减少预算,在人工收集下一轮优化数据时暂停训练),实际 GPU 时间约为 350 A100 小时。该方法适合个人规模或实验室规模的研究,因为 350 个 GPU 小时预算通常在 1K 美元内。

实验

图 6 展示了使用单图像基础模型生成的图像定性结果。这些结果展示了该模型可以生成原生透明图像,如生成高质量的玻璃透明度、头发、毛发、发光、火焰、魔法等效果。这些结果还证明了该模型可以泛化到不同的场景。

![图片[9]-ControlNet作者又出新作:百万数据训练,AI图像生成迎来图层设计-开放智能](https://nimg.ws.126.net/?url=http%3A%2F%2Fdingyue.ws.126.net%2F2024%2F0308%2Fa67d5a79j00sa0d3q00lyd200u000g7g00id009w.jpg&thumbnail=960x2147483647&quality=75&type=jpg)

图 7 展示了使用具有不同主题的提示来生成图片的定性结果。每个示例会显示混合图像和两个输出层。这些图层不仅在照明和几何关系方面保持一致,而且还展示了稳定扩散的美学品质(例如,背景和前景的颜色选择,看起来和谐且美观)。

![图片[10]-ControlNet作者又出新作:百万数据训练,AI图像生成迎来图层设计-开放智能](https://nimg.ws.126.net/?url=http%3A%2F%2Fdingyue.ws.126.net%2F2024%2F0308%2F3f68ee10j00sa0d4200xsd000u000m3c.jpg&thumbnail=960x2147483647&quality=75&type=jpg)

条件层生成。研究者在图 8 中展示了条件层生成结果(即以前景为条件的背景生成和以背景为条件的前景生成)。可以看到,本文的模型可以生成具有一致几何和照明效果的连贯构图。在「教堂中悬挂的灯泡」示例中,该模型尝试通过一种对称性审美设计来匹配前景。而在「坐在长登上或坐在沙发上」示例中,该模型可以推断前景和背景之间的交互,并生成相应的几何。

![图片[11]-ControlNet作者又出新作:百万数据训练,AI图像生成迎来图层设计-开放智能](https://nimg.ws.126.net/?url=http%3A%2F%2Fdingyue.ws.126.net%2F2024%2F0308%2Fbff8620aj00sa0d3s011jd200u000swg00id00ho.jpg&thumbnail=960x2147483647&quality=75&type=jpg)

迭代生成。如图 9 所示,研究者可以迭代使用以背景为条件的前景生成模型,以实现构图或任意数量的层。对于每个新的层,他们将之前生成的所有层融入到一个 RGB 图像,并馈入到以背景为条件的前景模型。研究者还观察到,该模型能够在背景图像的上下文中解释自然语言,比如在一只猫的面前生成一本书。该模型展现了强大的几何构图能力,比如生成一个人坐在箱子上的组合图像。

![图片[12]-ControlNet作者又出新作:百万数据训练,AI图像生成迎来图层设计-开放智能](https://nimg.ws.126.net/?url=http%3A%2F%2Fdingyue.ws.126.net%2F2024%2F0308%2F91f3720aj00sa0d3v00u2d200u000udg00id00ik.jpg&thumbnail=960x2147483647&quality=75&type=jpg)

可控生成。如图 10 所示,研究者展示了 ControlNet 等现有可控模型可以用于他们的模型,以提供丰富的功能。可以看到,本文的模型可以基于 ControlNet 信号来保留全局结构,以生成具有一致照明效果的和谐构图。研究者也通过一个「反射球」示例展示了本文的模型可以与前景和背景的内容进行交互,从而生成反光等一致性照明效果。

![图片[13]-ControlNet作者又出新作:百万数据训练,AI图像生成迎来图层设计-开放智能](https://nimg.ws.126.net/?url=http%3A%2F%2Fdingyue.ws.126.net%2F2024%2F0308%2F022987f3j00sa0d3x00god200u000dzg00id008j.jpg&thumbnail=960x2147483647&quality=75&type=jpg)