![图片[1]-ConsistentID,单张照片即可成为百变超人-开放智能](https://nimg.ws.126.net/?url=http%3A%2F%2Fdingyue.ws.126.net%2F2024%2F0511%2F9b79ea91j00sdbp29006yd200dw007tg00hx00a2.jpg&thumbnail=960x2147483647&quality=75&type=jpg)

上传一张个人照片就能瞬间变换身份,这不再是科幻片中的情节。

最近,图像生成技术经历了显著的进化,这是由基于扩散的, 文本到图像大型模型的出现和进步驱动的,如GLIDE 、DALL-E 2 、Imagen、稳定扩散(SD)、eDiff-I 和 RAPHAEL。

这一进展催生了跨不同场景的大量应用方法。作为这些应用方法的中心焦点,个性化和定制的肖像生成在学术和工业领域都引起了广泛关注,因为它在电子商务广告、个性化礼物定制和虚拟试穿等下游任务中具有广泛的适用性。

然而,定制化面部生成的主要挑战是基于一个或多个参考图像保持不同属性的面部图像一致性,导致两个关键问题:确保准确的身份(ID)一致性并实现高保真、多样化的面部细节。

当前的文本到图像模型,尽管结合了结构和内容指导,但在精确控制个性化和定制生成方面面临限制,特别是在生成的图像对参考图像的保真度方面。

近日,中山大学联合联想团队发布 ConsistentID,重新构建了一批50万的多模态细粒度 ID 数据集用于训练提出的 FacialEncoder 模型,可支持个性化写真,性别/年龄更改,身份混淆等常见功能。

![图片[2]-ConsistentID,单张照片即可成为百变超人-开放智能](https://nimg.ws.126.net/?url=http%3A%2F%2Fdingyue.ws.126.net%2F2024%2F0511%2F078373afj00sdbp29001wd200op00cbg00hx008x.jpg&thumbnail=960x2147483647&quality=75&type=jpg)

论文地址:http://arxiv.org/abs/2404.16771

HuggingFace ZeroGPU在线demo已发布:https://huggingface.co/spaces/JackAILab/ConsistentID

1

现有技术缺点

为了提高参考图像个性化人像生成的精度和多样性,出现了许多定制的方法,满足用户对高质量定制图像的需求。这些个性化方法根据推理过程中是否发生微调进行分类,从而产生两种不同类型的:测试时间微调和直接推理。

测试时间微调包括 TextInversion、 HyperDreambooth 和 CustomDiffusion 等方法。用户可以通过为训练后提供一组目标 ID 图像来实现个性化生成。尽管取得了值得称赞的高保真结果,但生成的输出的质量取决于手动收集的数据的质量。

此外,手动收集用于微调的定制数据引入了劳动密集型和耗时的方面,限制了其实用性。

直接推理是另一类模型,包括 IP-Adapter、Fastcomposer、Photomaker 和 InstantID ,采用单阶段推理方法。这些模型通过使用图像作为条件输入或操纵图像触发词来增强全局 ID 一致性。然而,大多数方法经常忽略细粒度的信息,例如地标和面部特征。

虽然 InstantID 通过引入地标在一定程度上提高了ID的一致性,但视觉提示地标限制了关键面部区域的多样性和可变性,导致生成的面部特征僵硬。

总之,需要细致考虑的两个关键挑战存在于个性化肖像生成中:1)忽略细粒度的面部信息和 2)面部区域与整个面部之间的身份不一致。

![图片[3]-ConsistentID,单张照片即可成为百变超人-开放智能](https://nimg.ws.126.net/?url=http%3A%2F%2Fdingyue.ws.126.net%2F2024%2F0511%2Febfdc83aj00sdbp2b00hqd200om00clg00hx0095.jpg&thumbnail=960x2147483647&quality=75&type=jpg)

ConsistentID的方法与现有方法之间的面部特征细节比较

值得注意的是,ConsistentID的方法生成的字符在眼睛、鼻子和嘴巴等面部特征中表现出卓越的 ID 一致性。

2

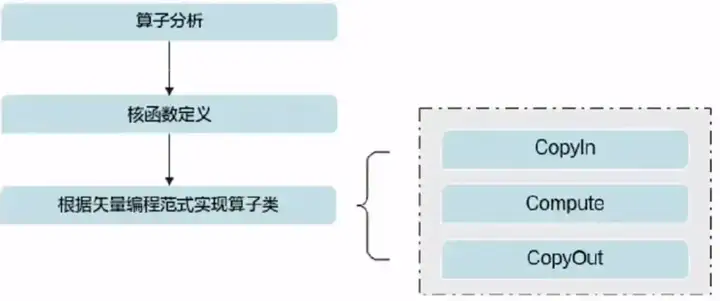

方法

![图片[4]-ConsistentID,单张照片即可成为百变超人-开放智能](https://nimg.ws.126.net/?url=http%3A%2F%2Fdingyue.ws.126.net%2F2024%2F0511%2F5bcf928fj00sdbp2d0086d200q900aig00hx0076.jpg&thumbnail=960x2147483647&quality=75&type=jpg)

提出的 ConsistentID 的总体框架

该框架包括两个关键模块:多模态面部 ID 生成器和有目的地制作的 ID 保存网络。多模态面部提示生成器由两个基本组件组成:细粒度多模态特征提取器,专注于捕获详细的面部信息,以及专门用于学习面部 ID 特征的面部 ID 特征提取器。

另一方面,ID 保存网络同时利用面部文本和视觉提示,通过面部注意力定位策略防止来自不同面部区域的 ID 信息混合。这种方法确保了面部区域 ID 一致性的保存。

为了应对这些挑战,引入了一种新的方法 ConsistentID,旨在保持身份一致性并通过多模态细粒度 ID 信息捕获不同的面部细节,在保证高保真度的同时仅使用单个面部图像。

ConsistentID 包括两个关键模块:多模态面部提示生成器和 ID 保存网络。前者包括细粒度的多模态特征提取器和面部 ID 特征提取器,从而能够使用多条件生成更详细的面部 ID 特征,结合面部图像、面部区域及其相应的从多模态大型语言模型 LLAVA1.5 中提取的文本描述。利用初始模块获得的面部 ID 特征,ConsistentID将它们输入到后一个模块中,通过面部注意力定位策略促进每个面部区域的 ID 一致性。

此外,ConsistentID 认识到现有肖像数据集的局限性,特别是在捕获多样化和细粒度的身份保留面部细节方面,这对于 ConsistentID 的有效性至关重要。为了解决这个问题,ConsistentID 引入了测量细粒度 ID 保存 (FGID) 数据集以及细粒度的身份一致性度量,提供了一种独特而全面的评估方法来增强 ConsistentID 在面部细节中的训练和性能评估。

3

评估

定性评估:为了证明 ConsistentID 的有效性,ConsistentID 对最先进的方法进行了比较分析,包括 Fastcomposer、IP-Adapter、Photomaker 和InstantID。ConsistentID 的重点是仅使用一个参考图像进行个性化生成。ConsistentID 利用官方提供的模型,对每种方法使用默认参数,并将推理限制为单个参考图像。与 Photomaker 方法对齐,ConsistentID 使用 Mystyle 数据集进行定量评估,并结合超过10个身份数据集进行可视化。

![图片[5]-ConsistentID,单张照片即可成为百变超人-开放智能](https://nimg.ws.126.net/?url=http%3A%2F%2Fdingyue.ws.126.net%2F2024%2F0511%2Fad68a496j00sdbp2f00x6d200ng00ipg00hx00ea.jpg&thumbnail=960x2147483647&quality=75&type=jpg)

研究进行了通用重新上下文化样本的定性比较,将 ConsistentID 的方法与使用五个不同身份及其对应的提示的其他方法进行了比较。ConsistentID的 ConsistentID 在高质量生成、灵活的可编辑性和强大的身份保真度方面表现出更强大的能力。

定量评估:遵循 Photomaker,ConsistentID 使用来自 Mystyle 的测试数据集,使用 MLLM LlaVA1.5 在推理过程中获得面部描述。定量比较是在通用重新上下文化设置下进行的,使用一组指标对各种方面进行基准测试。

对该表的彻底分析表明,在大多数评估指标中,ConsistentID 始终优于其他方法,并且在生成效率方面超过了其他基于 IP-Adapter 的方法。这归因于 ConsistentID 的细粒度 ID 保存能力和轻量级多模态面部提示生成器的效率。关于 FID 指标,较低的性能主要归因于基础模型 SD1.5 的有限生成能力。

![图片[6]-ConsistentID,单张照片即可成为百变超人-开放智能](https://nimg.ws.126.net/?url=http%3A%2F%2Fdingyue.ws.126.net%2F2024%2F0511%2Fcbf6252cj00sdbp2h010nd200q900gsg00hx00bg.jpg&thumbnail=960x2147483647&quality=75&type=jpg)

ConsistentID的模型与其他模型在风格化和动作指令两个特殊任务上的定性比较

4

未来工作

目前,ConsistentID 模型受限于数据集和基模型的训练,还未能做到类似海马体的出图效果。

据悉,该团队预计训练一个更大规模的 ConsistentID,基于 SDXL,整合了更大规模的 LAION-Face, VoxCeleb1, VGGFace2 等公开数据集,并且使用私有的高质量数据进行额外的微调。目的是为了使得 ConsistentID 可以具有更强大的泛化能力以及更强的出图质感,出图即用。

此外,为了调整出图的 ID 多样性,使得单张图片能生成姿态多变的写真图,正在训练的 ConsistentID 模型引入了多 ID 训练方式,用户可以同时输入多张图片来引导出图的变化。并且模型结构上也做了些许调整,保证 ID 特征和控制信息充分地解藕。

代码和最新进展将同步更新在github仓库中(https://github.com/JackAILab/ConsistentID)